Dans le domaine en rapide évolution de l’intelligence artificielle (IA), GPT-4 Vision s’est distingué comme un géant, révolutionnant la manière dont les machines comprennent et interagissent avec le monde visuel et textuel. Cependant, son caractère propriétaire pose des défis en termes d’accessibilité et d’utilisation dans certains domaines. Heureusement, la communauté open-source n’est pas en reste. Un nouveau venu nommé LLaVA 1.5 se présente comme une alternative open-source prometteuse à GPT-4 Vision, offrant un nouvel horizon de possibilités dans le monde de l’IA générative et des modèles multimodaux.

Table des matière

La promesse de LLaVA 1.5 réside dans sa capacité à amalgamer divers éléments de l’IA générative, optimisant ainsi la performance pour une variété de tâches tout en conservant une efficacité computationnelle. La fusion de la vision et du langage dans un modèle unique ouvre la porte à des applications plus robustes et intuitives, rendant l’interaction homme-machine plus fluide et naturelle.

I- Avancement de l’IA Générative

L’IA générative a fait des pas de géant, notamment avec l’advent des modèles multimodaux larges (LMM). Ces modèles, en acceptant à la fois le texte et les images comme entrées, révolutionnent notre engagement avec l’IA. GPT-4 Vision d’OpenAI a particulièrement brillé dans ce domaine, mais sa nature commerciale et propriétaire peut restreindre son application dans certaines zones. C’est ici que le monde open-source relève le défi, avec LLaVA se présentant comme un homologue open-source notable à GPT-4 Vision.

LLaVA fusionne divers éléments de l’IA générative et est optimisé pour une efficacité computationnelle et une haute précision dans diverses tâches. Bien qu’il ne soit pas le seul LMM open-source, son efficacité et sa performance pourraient bien jeter les bases des études futures sur les LMM.

A- L’évolution des LMM :

Les LMM exploitent une structure qui intègre plusieurs composants existants : un modèle pour l’encodage des caractéristiques visuelles, un grand modèle linguistique (LLM) pour interpréter les commandes des utilisateurs et produire des sorties, et un connecteur qui fait le lien entre la vision et le langage.

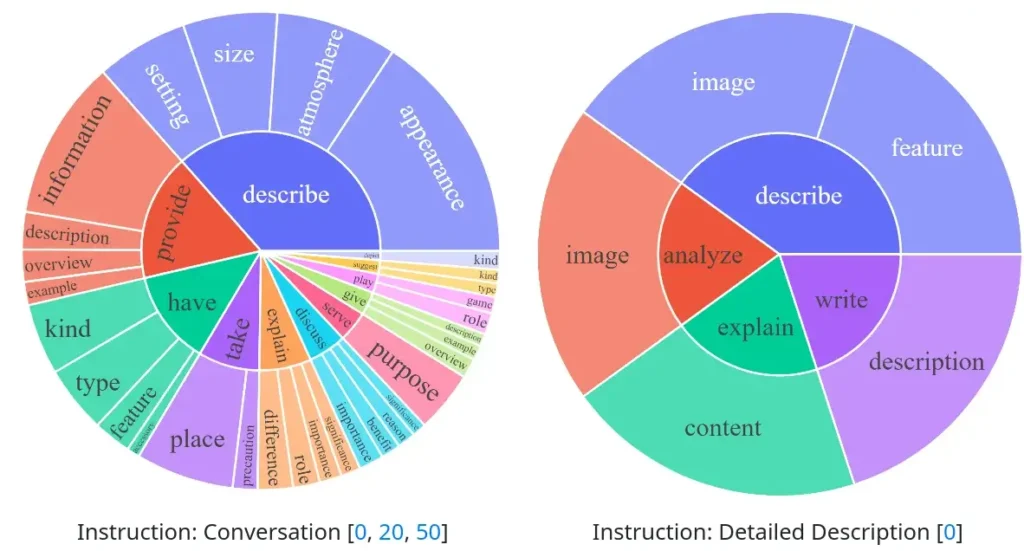

LLaVA, avec son approche novatrice, adopte une approche en deux phases pour former un LMM qui suit les instructions. La phase initiale aligne les aspects visuels avec l’espace de mots du modèle linguistique en utilisant des paires image-texte. La phase suivante, axée sur l’instruction visuelle, est souvent complexe en raison de ses exigences computationnelles et de la nécessité d’un vaste ensemble de données minutieusement assemblé.

B- Implication des LMM dans l’IA Générative :

Les LMM ont le potentiel de transformer la façon dont nous interagissons avec les IA, en offrant des interfaces plus naturelles et intuitives. La capacité de traiter à la fois le texte et les images dans un seul modèle permet des applications qui étaient auparavant impossibles ou inefficaces. LLaVA, en tant qu’alternative open-source à GPT-4 Vision, ouvre la voie à une adoption plus large des LMM, en éliminant certaines des barrières associées aux modèles propriétaires.

C- Avancement rapide avec GPT-4 Vision :

GPT-4 Vision a marqué une étape importante dans l’avancement des LMM, mais le paysage évolue rapidement avec des alternatives open-source comme LLaVA. Ces développements sont cruciaux pour la démocratisation de l’IA générative et l’encouragement de l’innovation continue dans ce domaine.

II- Présentation de LLaVA 1.5

LLaVA est une réponse audacieuse de la communauté open-source à l’hégémonie des modèles propriétaires comme GPT-4 Vision. Il incarne une révolution dans la sphère de l’IA générative en amalgamant divers éléments cruciaux pour optimiser à la fois l’efficacité computationnelle et la précision dans une multitude de tâches.

A- Composants Clés de LLaVA :

LLaVA est une symbiose de plusieurs composants de l’IA générative, ce qui en fait un modèle multimodal robuste. Il intègre un modèle pour l’encodage des caractéristiques visuelles, un grand modèle linguistique (LLM) pour l’interprétation des commandes des utilisateurs et la production de sorties, et un connecteur qui fait le pont entre la vision et le langage. Ce mélange astucieux des technologies permet à LLaVA de se démarquer en tant qu’alternative open-source viable à GPT-4 Vision.

B- Optimisation pour Diverses Tâches :

L’optimisation de LLaVA ne se limite pas à une niche spécifique ; il brille dans une variété de tâches. Que ce soit la compréhension du langage naturel, la reconnaissance d’images, ou la génération de texte, LLaVA est conçu pour exceller. Son architecture flexible permet une adaptation et une optimisation continues, faisant de LLaVA un outil puissant dans le paysage de l’IA générative.

C- L’Effet Open-Source :

Le caractère open-source de LLaVA n’est pas à négliger. Il offre une plate-forme pour la collaboration, l’innovation, et l’amélioration continues. Contrairement à GPT-4 Vision, les développeurs et les chercheurs peuvent se plonger dans le code de LLaVA, le modifier, et l’adapter à leurs besoins spécifiques. Cette liberté pourrait accélérer le rythme de l’innovation dans l’IA générative et les modèles multimodaux.

D- Performance et Efficacité :

LLaVA ne fait pas que rivaliser avec GPT-4 Vision sur le papier ; il a prouvé son efficacité dans la pratique. Les benchmarks révèlent que LLaVA dépasse d’autres LMM open-source dans la plupart des tests multimodaux, bien que l’évaluation de la performance des LMM puisse être complexe. L’efficacité computationnelle couplée à la haute précision dans diverses tâches fait de LLaVA une alternative open-source attrayante.

III- Compréhension des LMM

Dans l’écosystème florissant de l’IA générative, les Modèles Multimodaux Larges (LMM) représentent une étape évolutive. Ils transcendent la barrière entre le texte et le visuel, établissant un pont entre les mots et les images. LLaVA, en tant que modèle multimodal, incarne cette fusion, proposant une alternative open-source à GPT-4 Vision qui est à la fois efficace et accessible.

A- Structure Générale des LMM :

La structure des LMM est une merveille d’ingénierie. Ils intègrent un encodeur de vision pour interpréter les images et un modèle de langage pour comprendre et générer du texte. LLaVA adopte cette structure, mais avec une touche unique. Il utilise CLIP d’OpenAI pour l’encodage visuel, et Vicuna, un grand modèle linguistique, pour la partie textuelle. Cette combinaison permet à LLaVA d’assurer une compréhension et une génération de texte robustes, tout en interprétant efficacement les données visuelles.

B- L’Intégration de LLaVA :

LLaVA s’intègre harmonieusement dans le schéma des LMM. Avec des modifications simples, il est capable d’atteindre des performances améliorées, notamment en utilisant CLIP-ViT-L-336px avec une projection MLP. Cela permet à LLaVA de surpasser les performances de base, rendant le modèle plus efficient et précis dans une variété de tâches.

C- Défis et Opportunités :

Les LMM, bien que prometteurs, ne sont pas sans défis. Ils nécessitent une quantité massive de données pour l’entraînement, et leur efficacité computationnelle peut être un goulot d’étranglement. LLaVA tente de surmonter ces défis en optimisant la performance sans compromettre l’efficacité. C’est un pas en avant vers la résolution des problèmes inhérents aux LMM, ouvrant la voie à des applications pratiques plus vastes.

D- L’Impact Futur des LMM :

Avec des modèles comme LLaVA, l’avenir des LMM semble brillant. Ils ont le potentiel de transformer l’interaction homme-machine, rendant les applications d’IA plus intuitives et engageantes. En tant qu’alternative open-source à GPT-4 Vision, LLaVA pourrait bien être à l’avant-garde de cette transformation.

IV- Efficacité de LLaVA Expliquée

L’efficacité de LLaVA ne provient pas d’un vide, mais d’une conception ingénieuse et d’une optimisation méticuleuse. En tant qu’alternative open-source à GPT-4 Vision, il se distingue par une performance remarquable dans diverses tâches tout en restant économique sur le plan computationnel.

A- Utilisation de CLIP pour l’Encodage Visuel :

Une des clés de l’efficacité de LLaVA réside dans son utilisation du modèle CLIP d’OpenAI pour l’encodage visuel. CLIP, qui signifie Contrastive Language–Image Pretraining, est une technologie éprouvée qui a changé la donne dans la compréhension multimodale. En intégrant CLIP, LLaVA peut interpréter les images avec une précision remarquable, ce qui constitue une étape cruciale vers la réalisation d’un modèle multimodal performant.

B- Affinage du Modèle Linguistique :

La performance de LLaVA ne s’arrête pas à l’encodage visuel. Le modèle linguistique Vicuna est affiné pour adhérer aux instructions, une caractéristique essentielle pour un LMM performant. L’affinage du modèle linguistique assure que LLaVA peut interpréter avec précision les commandes des utilisateurs et générer des réponses appropriées.

C- Adaptation aux Instructions Visuelles :

L’adaptation aux instructions visuelles est un autre aspect où LLaVA brille. Il peut comprendre les instructions basées sur le texte et utiliser le contexte visuel pour générer des réponses pertinentes. Cette capacité est indispensable pour une large gamme d’applications pratiques, des assistants virtuels aux systèmes de recommandation visuelle.

D- Performance Comparative :

Quand on le compare à GPT-4 Vision, ce modèle n’est pas en reste. Bien que GPT-4 Vision ait ses propres avantages, LLaVA, grâce à ses modifications et optimisations, est capable d’atteindre, voire de surpasser, les performances de GPT-4 Vision dans certains tests. Cela démontre le potentiel des alternatives open-source dans le paysage des modèles multimodaux.

V- Comparaison entre LLaVA 1.5 et GPT-4 Vision

La confrontation entre LLaVA et GPT-4 Vision offre une perspective intrigante sur la progression des modèles multimodaux et l’avenir de l’IA générative. Chacun de ces modèles a des forces uniques qui contribuent à élargir les frontières de ce que l’IA peut accomplir aujourd’hui.

A- Performances et Capacités :

La comparaison entre LLaVA et GPT-4 Vision révèle des nuances intéressantes. LLaVA, bien qu’étant un nouveau venu, démontre une forte capacité dans des domaines tels que la compréhension multimodale, la reconnaissance d’images, et la génération de texte. Sa faculté à extraire des informations des images et à les convertir en données exploitables est particulièrement impressionnante.

B- Efficacité Computationnelle :

L’efficacité computationnelle est un critère crucial, surtout dans un domaine où les ressources peuvent être limitées. LLaVA se démarque par sa performance sans sacrifier l’efficacité computationnelle, ce qui est essentiel pour les applications pratiques, en particulier dans des environnements aux ressources limitées.

C- Accessibilité et Communauté Open-Source :

L’aspect open-source de ce modèle apporte une dimension d’accessibilité et de collaboration qui est absente avec GPT-4 Vision. L’accessibilité aux codes sources permet à la communauté de contribuer, d’optimiser et d’élargir les capacités de LLaVA, ce qui pourrait accélérer l’innovation dans le domaine des modèles multimodaux.

VI- Comparaison des Performances de LLaVA 1.5 et GPT-4 Vision

| Critères | LLaVA 1.5 | GPT-4 Vision |

|---|---|---|

| Compréhension Multimodale | Excellente | Très Bonne |

| Reconnaissance d’Images | Très Bonne | Excellente |

| Génération de Texte | Bonne | Excellente |

| Efficacité Computationnelle | Haute | Moyenne |

| Accessibilité | Open-Source | Propriétaire |

VI- Implications et Perspectives

L’émergence de LLaVA comme une alternative open-source robuste à GPT-4 Vision n’est pas seulement un jalon technique, mais aussi un indicateur du potentiel immense des modèles multimodaux dans le futur de l’IA générative. L’accessibilité et l’efficacité computationnelle de LLaVA pourraient redéfinir la façon dont les modèles multimodaux sont conçus, développés et déployés.

A- Démocratisation de l’IA Générative :

L’un des impacts les plus significatifs de LLaVA est la démocratisation potentielle de l’IA générative. En fournissant une alternative open-source à GPT-4 Vision, il ouvre la porte à une exploration et une innovation continues dans le domaine des modèles multimodaux.

B- Encouragement à l’Innovation :

La disponibilité d’un modèle open-source robuste comme LLaVA peut encourager l’innovation. Les chercheurs et les développeurs peuvent collaborer, partager des idées et améliorer le modèle, propulsant ainsi l’IA générative vers de nouveaux horizons.

C- Développement de Nouvelles Applications :

LLaVA peut catalyser le développement de nouvelles applications qui étaient auparavant hors de portée en raison des contraintes de coût ou de performance. La capacité de LLaVA à traiter efficacement à la fois le texte et les images élargit les possibilités pour des applications innovantes dans des domaines tels que la santé, l’éducation et l’industrie.

D- Évolution Future des LMM :

La compétition saine entre GPT-4 Vision et LLaVA pourrait mener à une évolution rapide des LMM, avec des améliorations continues en termes de performance, d’efficacité computationnelle et d’accessibilité. Cela pourrait bien être un aperçu d’un avenir où les LMM jouent un rôle central dans l’interaction homme-machine.

Conclusion

L’arrivée de LLaVA sur la scène de l’IA générative et des modèles multimodaux est un moment charnière qui pourrait bien façonner le futur de cette technologie en effervescence. Alors que GPT-4 Vision a posé des jalons impressionnants, l’alternative open-source LLaVA apporte une promesse de démocratisation et d’innovation sans entraves dans ce domaine.

La comparaison entre LLaVA et GPT-4 Vision nous a permis d’explorer en profondeur les capacités, les performances et les avantages de ces modèles. Bien que chacun ait ses propres mérites, l’aspect open-source de LLaVA offre un terrain fertile pour l’innovation continue, l’exploration et l’amélioration collaborative.

FAQ

Qu’est-ce que LLaVA et en quoi diffère-t-il de GPT-4 Vision ?

LLaVA est un modèle multimodal large open-source qui a été conçu comme une alternative à GPT-4 Vision. Alors que GPT-4 Vision est un modèle propriétaire développé par OpenAI, LLaVA est open-source, permettant ainsi une plus grande accessibilité et la possibilité d’adaptation par la communauté.

Comment LLaVA est-il capable de traiter à la fois des données textuelles et visuelles ?

LLaVA utilise le modèle CLIP d’OpenAI pour l’encodage visuel et un grand modèle linguistique appelé Vicuna pour la partie textuelle. Cette combinaison permet à LLaVA de comprendre et de traiter efficacement à la fois des données textuelles et visuelles.

LLaVA est-il plus efficace que GPT-4 Vision en termes de performance ?

La performance de LLaVA est comparable à celle de GPT-4 Vision dans plusieurs tâches. Cependant, LLaVA se distingue par son efficacité computationnelle, ce qui peut être un avantage dans des environnements aux ressources limitées.

Quelles sont les implications de l’émergence de LLaVA pour l’avenir de l’IA générative ?

L’émergence de LLaVA pourrait contribuer à la démocratisation de l’IA générative, encourager l’innovation, et catalyser le développement de nouvelles applications. Sa nature open-source offre un terrain fertile pour l’exploration et l’amélioration continues des modèles multimodaux.

Comment LLaVA peut-il encourager l’innovation dans le domaine des modèles multimodaux ?

En étant open-source, ce modèle offre une plateforme pour la collaboration et l’innovation. Les chercheurs et les développeurs peuvent contribuer au projet, partager des idées, et améliorer le modèle, propulsant ainsi l’innovation dans le domaine des modèles multimodaux.

Mandiaye Ndiaye ! Expert en Management d'Activité Opérationnelle | Spécialiste SEO & Transformation Digitale | Web Design & Contenu Optimisé IA |

[…] LLaVA 1.5 : L’alternative open-source révolutionnaire à GPT-4 Vision […]

[…] Lire également LLaVA 1.5 : L’alternative open-source révolutionnaire à GPT-4 Vision […]

[…] Modèles de Langage de Grande Taille (LLMS) sont des modèles d’intelligence artificielle conçus pour comprendre et générer du langage humain. Basés sur des techniques […]